©カネコブログ

robots.txtで見つかってしまう問題

2015.01.27

たまには技術的なポストも。

みなさん、robots.txtは使っていますか?

robots.txtとは、ロボット型検索エンジンに対する命令を記述するファイルの事です。

こんな感じ。

User-agent: *

Disallow: /test/

この場合、全て(*)の検索エンジンにおいて、testディレクトリだけクロールしないような命令になります。

その他にも色々知りたい方はこの辺りの詳しい方の解説をご覧ください。

で、どういう時使うかというと、テストアップ用ディレクトリやデータを入れておいたりしているディレクトリ、すなわちあまり知られたくないディレクトリを検索結果にインデックスしないでくれという感じで使います。

けれどこのrobots.txt自体はテキストデータなので、URLで叩くと見れてしまいます。

こんな感じ→http://xxxxx.com/robots.txt

それ自体は問題ないのですが、内容を見られてしまうと見られたくないディレクトリ名がバレてしまう。

そしてそのままそのURLを叩くと、見れてしまうという。

こんな感じ→http://xxxxx.com/test/

オー、なんてことだ。不条理な世界め。

これでは本末転倒だ。

そこで解決法。

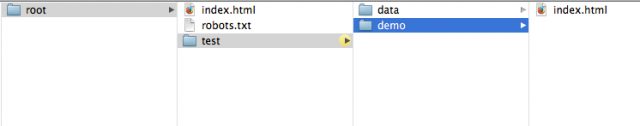

データをこんな感じでまとめるといいですね。

testの中にディレクトリを作り、そこに格納する。

こうする事で、test配下はクロールされないし、データ自体はどこにあるのか分からないという。

ただ、これはあくまで簡易での方法です!

本当に守りたい場合は認証などかけましょう。(少し面倒くさいんですよね)

ご利用は各々の責任で。

others